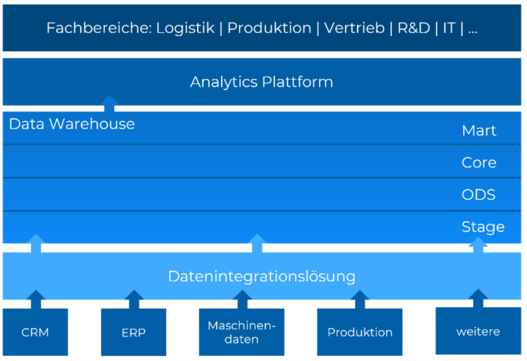

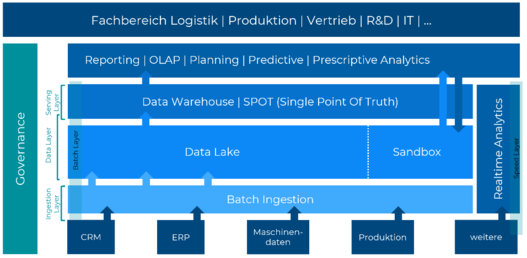

Geht es um die Speicherung großer Datenmengen, kommt man um die Begriffe Data Lake und Data Warehouse kaum herum. Vielen Unternehmen stellt sich früher oder später die Frage, welche der beiden Lösungen für welchen Anwendungsfall geeignet ist. In diesem Beitrag widme ich mich mit Erkenntnissen aus aktuellen Projekten in Kombination mit Erfahrungen und Versprechungen der Vergangenheit dem Thema Data Lake vs. Data Warehouse.

Dabei führt eigentlich schon der Titel in die Irre: „vs“ – wieso eigentlich „versus“, also entweder – oder? Das Thema „Data Warehouse“ ist und bleibt aktuell. Tatsächlich nehme ich bei unseren Kund*innen oft genau diese Vorstellung „entweder – oder“ wahr. In weiteren Gesprächen stellen wir zusammen fest, ob (und wie) ein integrierter Ansatz nicht viel sinnvoller ist, bzw. wie die beiden Ansätze sich ergänzen.