Ziel

Aufbau eines Data Lakes zur Konsolidierung und Bereinigung von Produktstammdaten und zur Analyse von Kundenbewegungsdaten

Dauer

12 Monate

System

IBM Cloud, Watson Services, Spark

Branche

Electronic

Typ

B2B

Onboarding

2018 - 2019

Der Kunde ist eine Kooperation von mittelständischen Elektrofachgroßhändlern mit mehr als 200 Verkaufsstellen in Deutschland und Österreich.

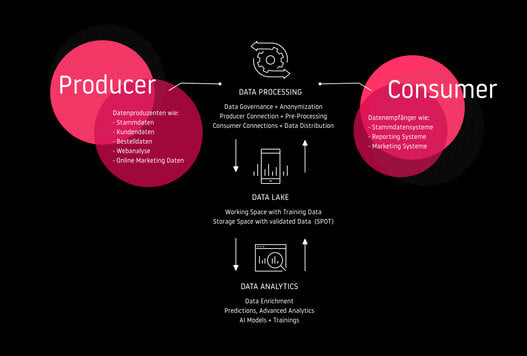

Die Herausforderung: Zusammenführung und Konsolidierung der Daten der Gesellschafter sowie die analytische Nutzung zur Optimierung von Einkauf, Logistik und Verkauf; dies unter besonderer Berücksichtigung der Datenhoheit der Gesellschafter sowie der DSGVO.

Die Lösung: Aufbau eines Systems zur Anbindung der verschiedenen datentragenden Systeme der Gesellschafter sowie zur Bereinigung, Klassifizierung und Verknüpfung der unterschiedlichen Datenbestände unter Einbeziehung spezialisierter Machine Learning-Algorithmen.

Entwicklung und Training von KI-Modellen und -Algorithmen in den Feldern Data Cleansing und Data Classification, Textmining und Image Analysis, Predictions und Recommendations, Forecasting und Reporting.

Der Mehrwert

Die Nutzbarmachung der Daten aller ermöglicht es dem einzelnen Gesellschafter, tiefere und genauere Einblicke in das Nutzer- und Käuferverhalten zu bekommen, als er sie aus seinen eigenen Daten gewinnen könnte. Predictions und Forecasts gewinnen durch die breitere Datenbasis an Genauigkeit und fördern den Absatz über die verschiedenen Kanäle von der Fläche bis zum Online-Shop.

Die Konsolidierung der Daten aller Gesellschafter erhöht die Datenqualität und reduziert Redundanzen und Dubletten zwischen den Systemen. Die offene und primär auf Opensource-Produkten realisierte Architektur ermöglicht die notwendige Flexibilität und Skalierbarkeit in der Anbindung und Verarbeitung verschiedenster Datenquellen.

Ein zentraler “Single-Point-of-Truth” zur Konsolidierung und Speicherung aller unternehmens- und kundenrelevanten Daten.

Die Technik

- Zur Anbindung der verschiedenen Gesellschaftersysteme sowie der Steuerung der Data Cleansing und Data Mapping Prozesse wird eine Java-basierte Online-Applikation eingesetzt. Sie integriert zudem die notwendigen Data Governance-Regeln und übernimmt die Anonymisierung und Deanonymisierung der Gesellschafter- und Kundendaten.

- Der performante und skalierbare “Data Lake” wird mittels MongoDB-Instanzen umgesetzt.

- Advanced Analytics und die Entwicklung der KI-Modelle und -Algorithmen wird mittels Apache Spark realisiert.

- Das gesamte System läuft innerhalb einer Private Cloud der IBM Cloud in Deutschland.